UX디자이너가 알아야 할 인공지능 윤리 요소 3가지

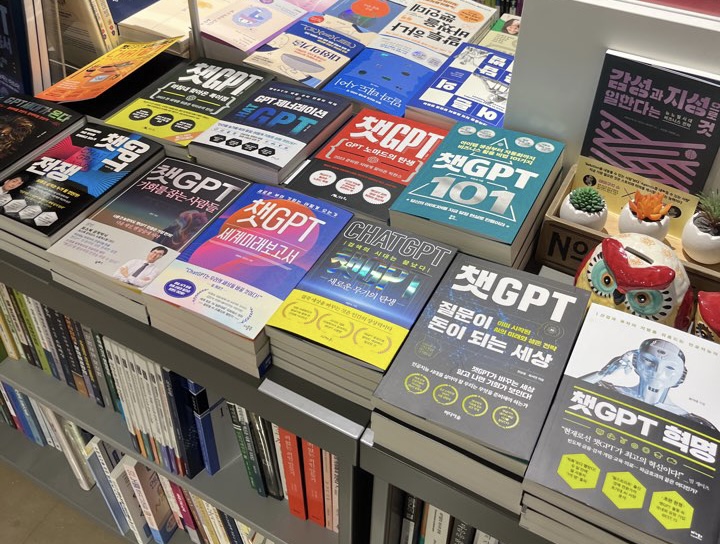

몇 일 전 영풍문고에 갔다. 눈에 띈 건 ‘챗GPT’라는 단어가 들어간 책들이 매대 하나를 가득 채우고 있는 모습이었다. ‘디자이너와 인공지능의 협업’에 대해 연구하며 글도 쓰고 강의도 하고 있지만 이 광경을 보니 징그럽다는 생각이 드는 걸 막을 수 없었다. 한편으로는 걱정스러운 마음도 들었다. 기술의 발전에는 항상 부작용이 따라오기 때문이다. 핵전쟁의 위험성, 자연환경 파괴, 개인 사생활 침해 등 과학의 힘이 커질수록 부정적인 영향력도 커지기 마련이다.

챗GPT에 대해서도 이미 많은 윤리적 문제가 제기되었다. 출시된 직후, 한 달 동안 챗GPT와 관련된 30만 건 이상의 트윗을 수집·분석한 연구를 살펴보면, 공통적으로 언급된 문제는 총 4가지로 편견 확산, 신뢰성, 유해성, 할루시네이션*이었다. 하지만 이러한 문제들이 챗GPT를 사용하는 모든 분야에 공통적으로 나타난다고 보기는 어렵다. 예를 들면, 교육 및 과학 분야에서는 편견 및 편향 확산이, 예술 분야에서는 저작권이 가장 큰 문제로 논의되고 있다. 그렇다면, 디자인 씽킹(Design Thinking)을 통해 사용자 경험을 개선하는 UX디자인 분야는 어떨까?

*할루시네이션(Hallucination): 환각이라는 뜻으로 인공지능이 잘못된 허위 정보를 생성하는 것을 의미

이전 글 <ChatGPT와 미드저니로 넷플릭스 UI리디자인하기>에 기록했듯, UX디자인 작업에도 생성형 인공지능 도구들을 충분히 활용할 수 있다. 최근 필자는 직접 UX/UI 디자인 실무자 10명을 대상으로 ‘Uxer와 AI 협업 모델의 효과성과 UX디자이너의 윤리적 인식 실태 조사’를 실시했다. 이를 위해 참가자들은 ChatGPT와 미드저니를 협업 도구로 활용해 입력, 생성, 의사결정을 반복하며 넷플릭스 모바일의 UX/UI를 리디자인하는 과제를 받았다. 과제를 완료한 뒤 AI와 협업한 효과와 그 과정에서 디자이너의 역할 변화, 한계점 등에 대해 1:1로 30분간 심층 인터뷰했다. 그 결과 모두가 입을 모아 시간 단축, 비용 절감, 작업 효율 면에서 굉장히 효과적이라고 이야기했다. 반면, 실험에 참가한 실무자들이 공통적으로 말했던 문제도 있었다. 이 글에서는 그 3가지 문제에 대해, 위 *실험 결과를 바탕으로 정리해보고자 한다.

1. UX디자이너가 주의해야 할 인공지능 윤리: 데이터 신뢰성

생성형 인공지능은 허위 사실이나 오해의 소지가 있는 정보를 생성할 수 있으며, 최신 데이터를 업데이트 하지 않을 경우 부정확한 정보를 출력할 수 있다. 이 모든 현상을 일컬어 ‘할루시네이션(Hallucination)’이라고 말하는데, 이는 생성형 인공지능의 고질적인 문제로 꼽힌다. 이번에 새로 출시된 GPT-4 모델의 경우에도 할루시네이션 현상을 ‘개선’하기는 했지만 아직 완전히 보완한 단계는 아니라고 한다. 그렇기 때문에 인공지능이 출력한 데이터를 활용한 작업을 할 때는 그 데이터를 검증하는 작업이 필수로 요구된다.

하지만 앞서 말했던 실험에 참가한 UX/UI 디자인 실무자들의 경우, 인공지능이 생성한 데이터의 신뢰도에 대해 상반된 의견을 보였다. 먼저, 생성된 데이터에 대해 의심을 했던 실무자들은 인공지능이 명확한 근거를 제시해주지 않기 때문에 답변을 신뢰할 수 없다고 이야기했다. 반면, 챗GPT는 수많은 의견의 집합체이기 때문에 보다 객관적인 판단을 도와준다는 점에서 신뢰할 수 있다는 의견도 있었다.

또한, AI를 인간처럼 대하며 높은 신뢰도를 보이는 실무자들도 있었다. 예를 들면, AI가 오답을 제시했을 때 화를 낸 후 사과를 한다거나, 옳은 답변을 주면 ‘정말 잘했어. 고마워’등의 인사와 함께 칭찬을 하는 등 AI를 마치 감정이 있는 생명체로 대하는 모습이 관찰되었다. 이들은 공통적으로 AI에 대한 높은 신뢰도를 보였는데, 여기서 우려되는 점은 ‘엘리자(Eliza) 효과’다. 엘리자 효과에 따르면 AI를 인간처럼 느낄 경우, 실제보다 더 똑똑하다고 믿게 된다고 한다. 하지만 위에서 말했듯, AI는 허위 정보를 생성할 수 있는 가능성이 있고 그에 대한 사실 여부를 스스로 검증할 수 없다. 따라서 AI가 생성한 데이터에 대해 무조건적으로 신뢰하는 대신, 비판적으로 검토하고 사실을 검증하여 판단하는 것이 필요하다.

2. UX디자이너가 주의해야 할 인공지능 윤리: 편향된 정보

생성형 AI는 인터넷 상에 있는 데이터를 학습한다. 따라서 특정 그룹에만 집중하여 그 외의 그룹들은 배제되는 결과가 나타날 수 있다. 특히 챗GPT의 경우, 주로 영어 데이터를 학습했기 때문에 영어를 사용하는 문화권의 데이터를 기반으로 답변을 생성한다. 따라서 한국인이나 영어 문화권이 아닌 다른 문화권을 대상으로 사용자 조사를 해야 하는 UX디자이너라면 이와 같이 편향된 정보를 주의해야 한다.

편향성은 사용하는 언어에 따라서도 문제가 된다. 실험에 참가한 UX/UI실무자 10명 중 9명이 모두 챗GPT에 한국어로 질문을 입력했다. 지금은 많이 개선되어 한국어로도 답변을 잘 해준다고는 하지만, 여전히 영어 데이터를 더 많이 학습했다는 점은 동일하기 때문에 답변에 대한 정확도와 일관성이 떨어질 수 있다. 실제로 실무자들은 한국 사용자의 고유한 문화와 특성을 반영하지 않은, 일반적인 답변만 생성되어 정확한 문제를 파악하기 어려웠다고 한계를 토로했다.생성형 AI는 학습된 데이터만을 다루기 때문에 실무에서는 앞으로도 계속 직접 사용자 조사를 해야 한다고 이야기하기도 했다.

이는 인간만이 가지고 있는 ‘공감 능력’과도 연결되는 이야기다. UX디자인은 같은 인간으로서 사용자를 이해하고 공감하며 문제를 풀어가야 하는 작업이다. 따라서 이러한 능력이 없는 AI가 아무리 편향된 정보를 생성한다고 하더라도 우리 인간 디자이너들은 이를 검증하고 사용자를 위한 최적의 전략을 도출해낼 수 있다. 실무자들도 이 문제에 대해 “공감 기반 의사 결정은 AI가 수행할 수 없는 작업으로 UX디자이너의 역할로 남을 것이다.”, “앞으로 인간 친화적인 의사결정을 위해 인간의 본질을 탐구하는 것이 더욱 중요해질 것이다.”라고 이야기하며 인간적인 사고의 중요성을 강조했다.

3. UX디자이너가 주의해야 할 인공지능 윤리: 일자리 위협

인공지능이 발전하고 신기술이 출시될 때 마다 매번 언급되는 문제가 있다. 바로 “고용 위협”, “실업률 증가”에 대한 우려다. 특히, 이번에 나온 챗GPT나 미드저니, Dalle-2 등과 같이 고도화된 생성형 AI 기술은 이러한 우려를 더욱 증폭시켰다. UX/UI 실무자들도 이미 회사 업무에 많이 활용하고 있다고 이야기하며, “디자이너에 대한 전망이 밝지 않다.”, “이런 시기가 이렇게 빨리 올 줄은 몰랐다. 진짜 큰일 났다.”라고 두려움을 표현했다.

하지만, UX/UI 실무자 10명과 함께 했던 이번 실험에서는 6개의 미션을 수행하기 위해 AI의 생성이 필요한 작업은 5번, 생성된 답변을 바탕으로 디자이너의 의사결정이 필요했던 건 6번이었다. 또한, 평균적으로 15번의 프롬프트 입력이 이루어졌으며 소요 시간은 약 59분이었다. 이를 통해 생성형AI가 UX디자이너의 업무를 대체하는 것이 아닌 협업 관계에서 함께 작업을 하고 있다는 걸 알 수 있다. 특히, 최종 결과물을 보면 UX디자이너의 역할이 더욱 돋보인다. 예를 들면, AI가 ‘추천 기능’이라는 하나의 문제를 언급하더라도 추천 기능을 강화하는 방향으로 디자인을 개선하는 디자이너가 있는가 하면, 오히려 추천 기능의 부작용인 *필터버블을 우려하여 무작위 추천 기능을 추가하는 방향으로 개선하기도 하는 디자이너도 있었다.

*필터버블: 알고리즘 등 사용자 맞춤형 정보를 제공하는 기술로 인해 보던 것만 보고 알던 정보만을 접하게 되는 현상

또한, 앞서 언급한 데이터 신뢰성, 편향성 등의 윤리적 문제를 고려했을 때, UX디자이너와 AI의 협업 과정에서 디자이너의 역할은 여전히 필요하며, AI가 인간 디자이너의 업무를 완전히 대체하기는 어려울 것으로 예상할 수 있다.

4. 마치며

UX/UI실무자들과 함께 했던 이번 실험을 통해 알 수 있는 건, AI를 실무에 사용하더라도 의사결정 권한은 여전히 디자이너가 갖고 있으며, AI는 보다 효율적인 업무 수행을 위한 협업 도구로써 활용되고 있다는 점이다. 실무자들은 미션 수행 후, “어떻게 질문을 하는지에 따라 답변에 깊이가 달라진다. 질문하는 역량이 중요하다.”, “앞으로는 AI와 어떻게 협업하는지 그 활용 역량이 업무 수행 평가 기준이 될 것 같다.”라고 이야기 했는데, 그처럼 앞으로는 인공지능과 어떻게 소통을 하는지가 중요해질 것이다.

공감능력, 사고력, 창의성, 비판적 사고 등 인간만이 가질 수 있는 역량들을 강화하기 위해 대비하는 디자이너라면, AI가 상용화되는 근미래에도 전문가로서 자리를 지킬 수 있지 않을까 생각한다. 나아가, 이번 글에서 언급한 세 가지 인공지능 윤리 요소까지 고려하여 업무에 활용할 수 있다면, 인공지능은 더 이상 두려움의 대상이 아닌, 효과적이고 효율적인 디자인 작업을 할 수 있도록 도와주는 동료가 되어줄 수 있을 것이다.

<참고 논문>

- Zhuo, T. Y., Huang, Y., Chen, C., & Xing, Z. (2023). Exploring ai ethics of chatgpt: A diagnostic analysis. arXiv preprint arXiv:2301.12867.

- Weizenbaum, J. (1966). ELIZA—a computer program for the study of natural language communication between man and machine. Communications of the ACM, 9(1), 36-45.

- Harin Y., Soojin J. (2023). Ethical Awareness of UXers in the Loop. In International Conference on Mobile Human-Computer Interaction. Athene. https://doi.org/10.1145/3565066.3608691.

- Lowrey, A. (2023). How ChatGPT will destabilize white-collar work. The Atlantic, 20.

- Xu, W. (2019). Toward human-centered AI: a perspective from human-computer interaction. interactions, 26(4), 42-46.

©️요즘IT의 모든 콘텐츠는 저작권법의 보호를 받는 바, 무단 전재와 복사, 배포 등을 금합니다.