A/B 테스트 제대로 이해하기: ①테스트를 설계할 때 우리의 진짜 질문은?

서비스 기획, PM, 그리고 그로스 해킹과 관련한 부트캠프나 신입 교육 과정을 살펴보면, A/B 테스트에 관한 이야기가 많다. 아마도 서비스를 개선하는 실험 방안 중 하나로 A/B 테스트가 가장 유명(?)하기 때문일 것이다. 그도 그럴 것이 A/B 테스트와 관련해서 오바마 대선 캠페인같은 사례들이 이미 일반인들에게도 알려진 상황이다.

문제는 그 중 상당수가 ‘트래픽을 절반으로 나눈다’, ‘변수는 1개만 둔다’ 등 A/B 테스트의 사례나 세팅 방법 정도로 설명이 그치는 경우가 있다. 그래서 신입 또는 직무 취업준비생의 과제나 질문을 보면, 단순히 아무거나 A와 B안으로 분리한 다음 가져와서 '더 나은 놈을 살려주겠다'라는 식으로 과제를 마무리하는 모습을 종종 발견하게 된다.

그런데, A/B 테스트는 정말 A와 B안(또는 경우에 따라 C, D, E안....)을 가져와 균등한 트래픽으로 나누어 동시간대에 진행하기만 하면 되는 걸까? A/B 테스트를 통해 우리가 알고 싶은 건 정말 ‘목표를 달성하기 위한 방안으로 A안과 B안 중 어느 게 더 효과가 좋은가?’가 끝인 걸까?

A/B 테스트를 설계할 때 우리가 진짜로 궁금해하는 것

A/B 테스트를 설계할 때 표면상으로 우리의 궁금증은 ‘목표를 달성하기 위한 방안으로 A안과 B안 중 어느 게 더 효과가 좋은가?’일지도 모른다. 그러나 사실 우리의 '진짜' 궁금증은 이것보다 더욱 복잡하고 섬세하다.

우리의 표면상의 질문 뒤에 숨은 진짜 질문을 정의하기 위해, 몇 가지 가상의 실험 결과를 생각해보자.

1) 우리는 암묵적으로 A/B 방안의 결과가 상당히 크길 바란다.

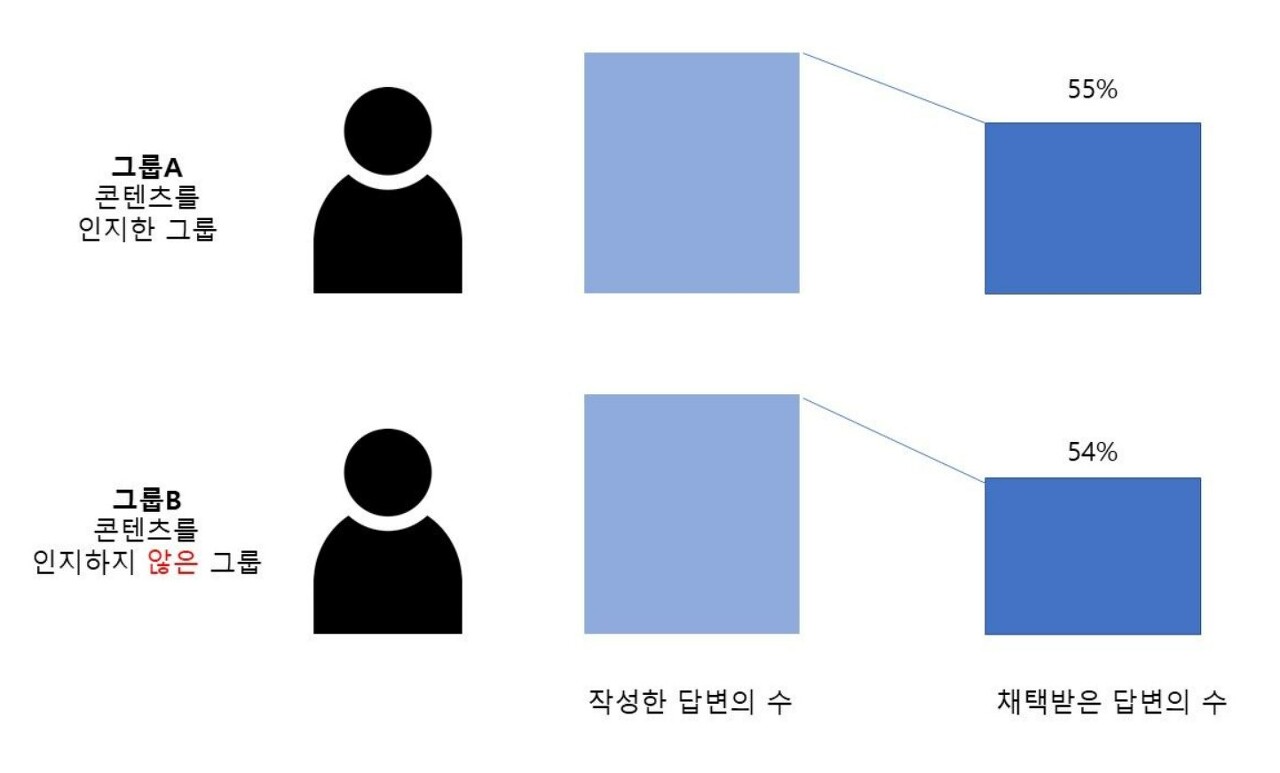

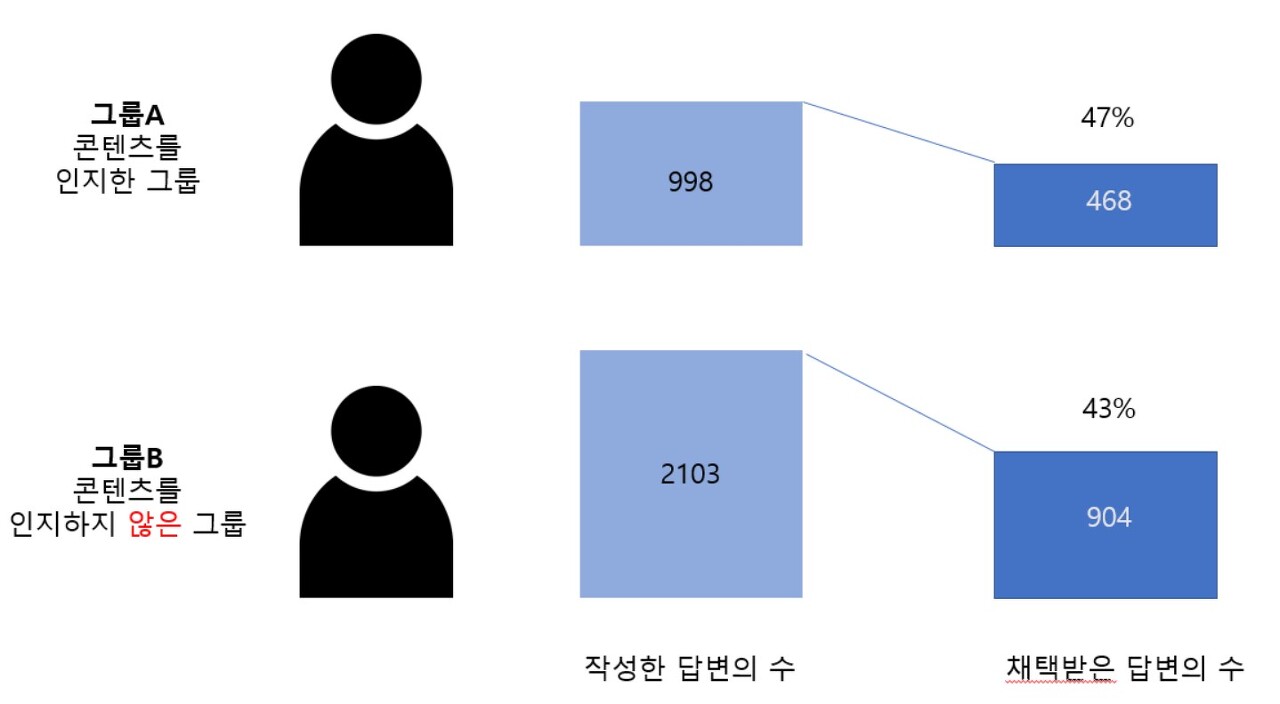

만약 네이버 지식in 서비스에서 답변을 남기는 이들이 더 좋은 답변을 남길 수 있도록 유도하는 콘텐츠를 제공하고, 좋은 답변의 기준을 '답변 채택률'로 보는 실험 설계를 가정해보자. 두 그룹의 구성원이 각각 적게는 몇 개 ~ 많게는 수십 개의 답변을 작성한 후 (모든 답변이 채택을 받는 것은 아니므로) 이들의 답변 중 '채택받은 답변'으로 전환되는 비율(%)을 비교하는 실험이다.

실험 결과, A와 B 집단의 채택 전환율 차이는 1%p로 A가 승리했다. A와 B 중 A가 1%p라도 높으니 일단은 A가 이겼다고 하면 될까? 이런 경우, 보통 우리는 ‘무엇인가 찝찝하다’라고 생각할 것이다. 왜냐하면 1%p는 별로 차이가 나지 않기 때문이다. 즉, 우리는 A/B테스트를 할 때 두 실험 결과의 차이가 '상당히 크거나 확실하길' 바란다.

2) 우리는 실험의 진행이 공정하길 바란다.

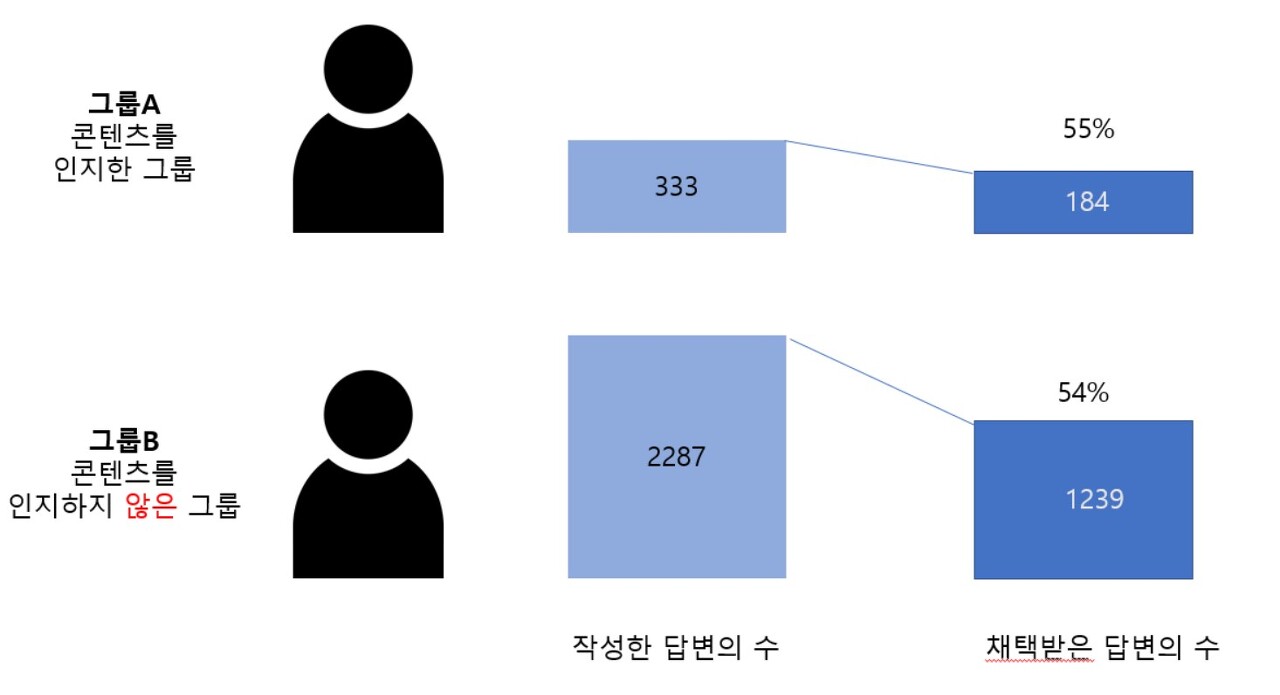

그리고 그 공정함의 실체가 무엇인지는 아무도 모른다. 만약 최대한 트래픽을 균등하게 나누려고 했지만, 어떠한 이유로 두 그룹에 노출되는 비율에 차이가 생겼다고 가정해보자. A그룹은 전환율이 55%이지만, 333개의 답변 중 184개가 채택되었다. 반면 B그룹은 전환율이 1%p 낮은 54%지만 무려 2,287개의 답변 중 1,239개의 답변이 채택됐다.

그럼 이 경우에도 우리는 A그룹에게 적용한 방안이 무조건 낫다고 생각할까? 비율은 1%p 차이밖에 안 나는데, 결과적으로 B그룹이 좋은 답변을 1,055개나 더 많이 작성했으니 B 그룹이 더 나은 건 아닐까? 혹시 두 그룹의 비율이 다르니, 비교를 하지 않는 게 옳은 건 아닐까?

이처럼 우리는 A/B 테스트를 할 때 공정함의 실체가 무엇인지도 모르면서 진행이 공정하길 바란다. 그래서 자신도 모르게 ‘실험 배경이 5:5로 동일하다’라고 생각하게 된다.

3) 우리는 이번 실험의 결과가 이례적이거나 우연이 아니길 바란다.

앞서 A/B 테스트를 처음 진행하는 상당수가 ‘트래픽을 절반으로 나눈다’라는 가설을 갖춘다고 설명했다. 위의 실험을 보면 A와 B의 결과 차이도 그다지 크지 않고, 표본 비율마저 5:5가 아니라서 실험이 공정하지 않다고 생각할 수 있다. 그래서 같은 실험을 한 차례 더 진행해보기로 가정해 보자.

이번에도 작성한 답변의 수(트래픽)가 정확히 5:5로 나뉘진 않았지만 이전 실험에 비해 채택받은 답변의 수는 상당히 격차가 줄어들었다. 그리고 무엇보다 두 그룹의 전환율 차이가 1%p에서 4%p로 증가했다. 트래픽은 차이가 있지만, 어쨌든 4%p라면 그래도 제법 괜찮은 비율 같아 보인다.

그런데 같은 조건, 같은 실험이었는데 이전과 다르게 이번엔 4%p 차이가 났다. 이에 우리는 고민한다. '실험마다 이렇게 결과가 다르다면, 이 실험을 우리는 믿을 수 있는 걸까?'

즉, 우리는 A/B 테스트로 실험해서 나온 결과가 어쩌다 나온 이례적인 경우이거나 우연이 아니기를 바라게 된다.

A/B 테스트의 진짜 질문

즉, 우리가 A/B 테스트를 설계하거나 진행할 때 지닌 표면상의 질문인 “목표를 달성하기 위한 방안으로 A안과 B안 중 어느 게 더 효과가 좋은가?” 뒤에 숨은 진짜 질문은 다음과 같다.

“이번 며칠 동안 모은 000명~0,000명의 트래픽/고객에 대해서만 유효한 게 아니라, 앞으로도 & 해당 유형의 모든 고객에게 A안과 B안 중 어느 게 ‘확실하게’ 효과가 좋은가? 이 결과는 정말로 A와 B의 차이 덕분에 생긴 게 맞는 걸까? 그리고 이 결과는 우연이 아닌 걸까?”

이렇게 숨은 질문을 생각하면 A/B 테스트의 설계와 결과 해석을 1) 트래픽을 절반으로 나누거나 2) 변수를 하나만 두거나 3) 또는 더 나은 결과를 보여주는 방안을 선택해서 배포하는 식으로 단순하게 정의할 수 없게 된다.

그렇다면 우리가 궁금한 진짜 질문에 관한 답을 얻기 위해 A/B 테스트의 설계나 결과 해석 과정에서 유의할 점은 무엇일까? 상세한 정보와 이를 분석하기 위해 알아야 할 기초 통계에 대해서는 2편에서 자세히 설명하겠다.

©️요즘IT의 모든 콘텐츠는 저작권법의 보호를 받는 바, 무단 전재와 복사, 배포 등을 금합니다.